如何在本機 Offiline 免費無限運行 ChatGPT?

由於早前出 Trip 時遇上沒網路就沒 ChatGPT 用的困境,雖然有手機網路但酒店網路不穩定也不一定可以穩定連線。所以就再找 Ollama 找出來看看現在可以使用什麼新 Model 可以在本機不用網路的情況下使用 LLM 工作。

由於早前出 Trip 時遇上沒網路就沒 ChatGPT 用的困境,雖然有手機網路但酒店網路不穩定也不一定可以穩定連線。所以就再找 Ollama 找出來看看現在可以使用什麼新 Model 可以在本機不用網路的情況下使用 LLM 工作。

之前也有介紹跟 Stable Diffusion 一起使用 Ollama,作為在本機運行 LLM (Large Language Model) 的工具其實 Ollama 也可以個別運作。同時因為是 Open source 的原故,所以可以實現免費無限量使用!

今次的會教大家使用更簡單的方法本地安裝 LLM 同時有繁體中文的 WebUI 可以使用,此方法同時支援 Windows / Mac / Linux。

首先要安裝 Docker Desktop

最簡單又不需要用 Python 的軟件的方法就是用 Docker,安裝 Docker Desktop 是最簡單的 Docker 安裝方法,如果不太會用 Docker 就可以安裝 Docker Desktop。支援 Windows / Mac / Linux。

安裝 Open WebUI

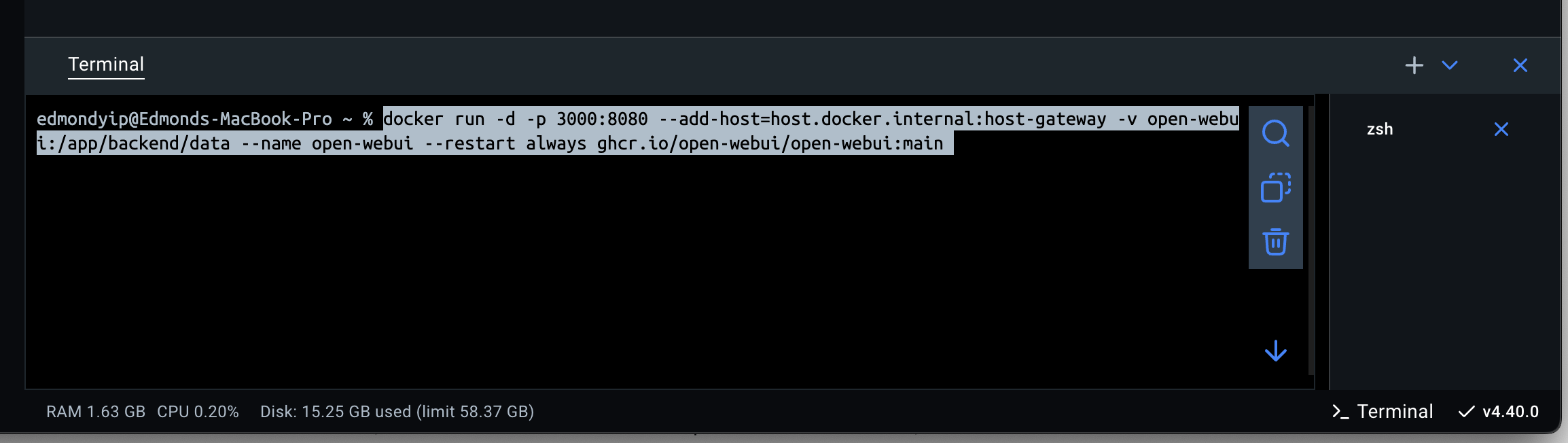

安裝 Docker Desktop 後,按 Docker Desktop 右下角 Terminal 打開介面,copy 適用於你電腦的 command

如果你的電腦支援 Nvidia GPU,就是有在用先進的 Nvidia 顯示卡,就用這個指令:

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama如果你是用 Mac 或者沒有 Nvidia GPU 或者你都不知道,就用這個指令

docker run -d -p 3000:8080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama分別在於是否使用 Nvidia GPU 加速,使用了會快一點就是。

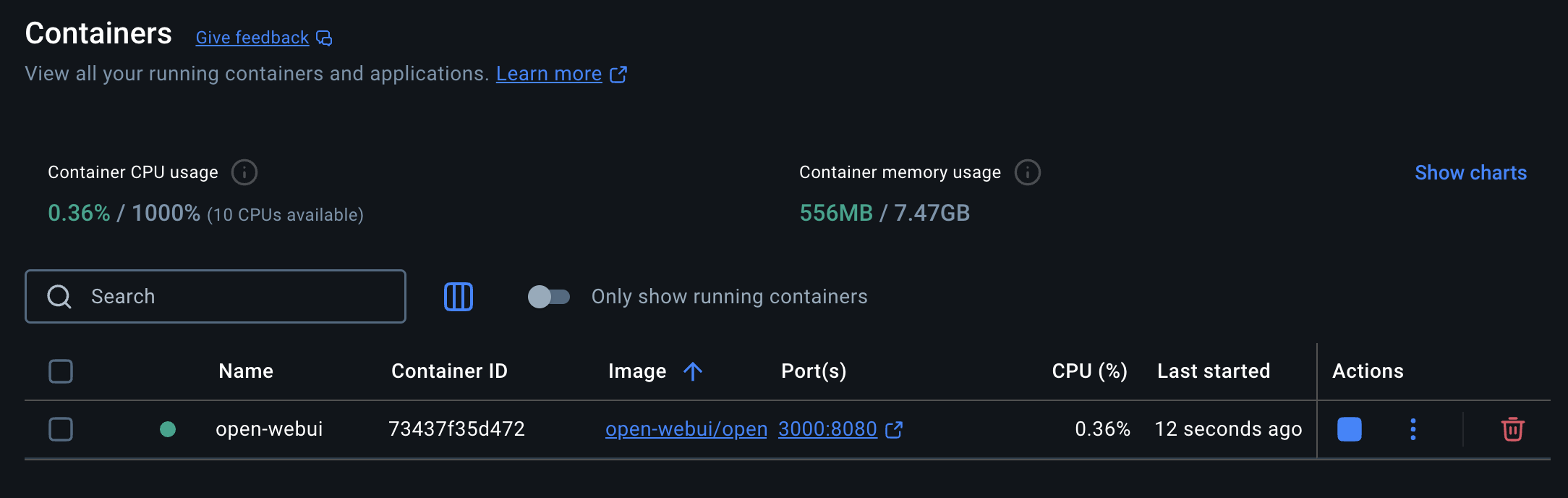

輸入指令後會自動下載安裝 Open WebUI 及 Ollama,成功後會自動啟動 container。

此時打開 http://localhost:3000 就可以見到你的 Open Webui 畫面。

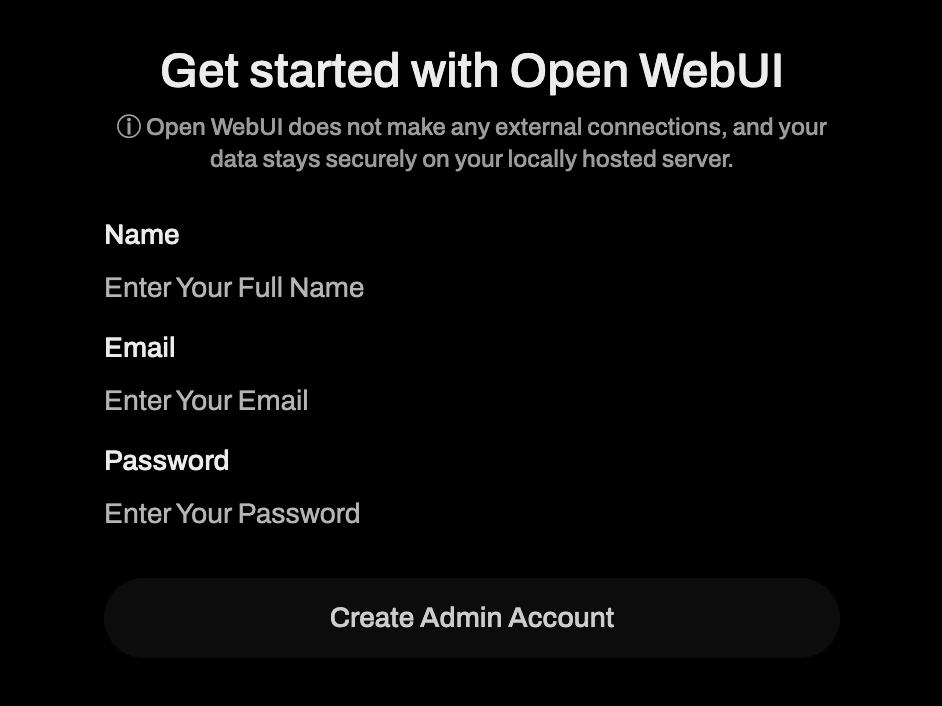

按 Get started 去到建立帳號畫面,這個帳號只會儲存在你本機 Docker 內,不是任何網站或服務的帳號,你也可以在家或公司自設 server,這樣就可以給不同的用家一起使用。

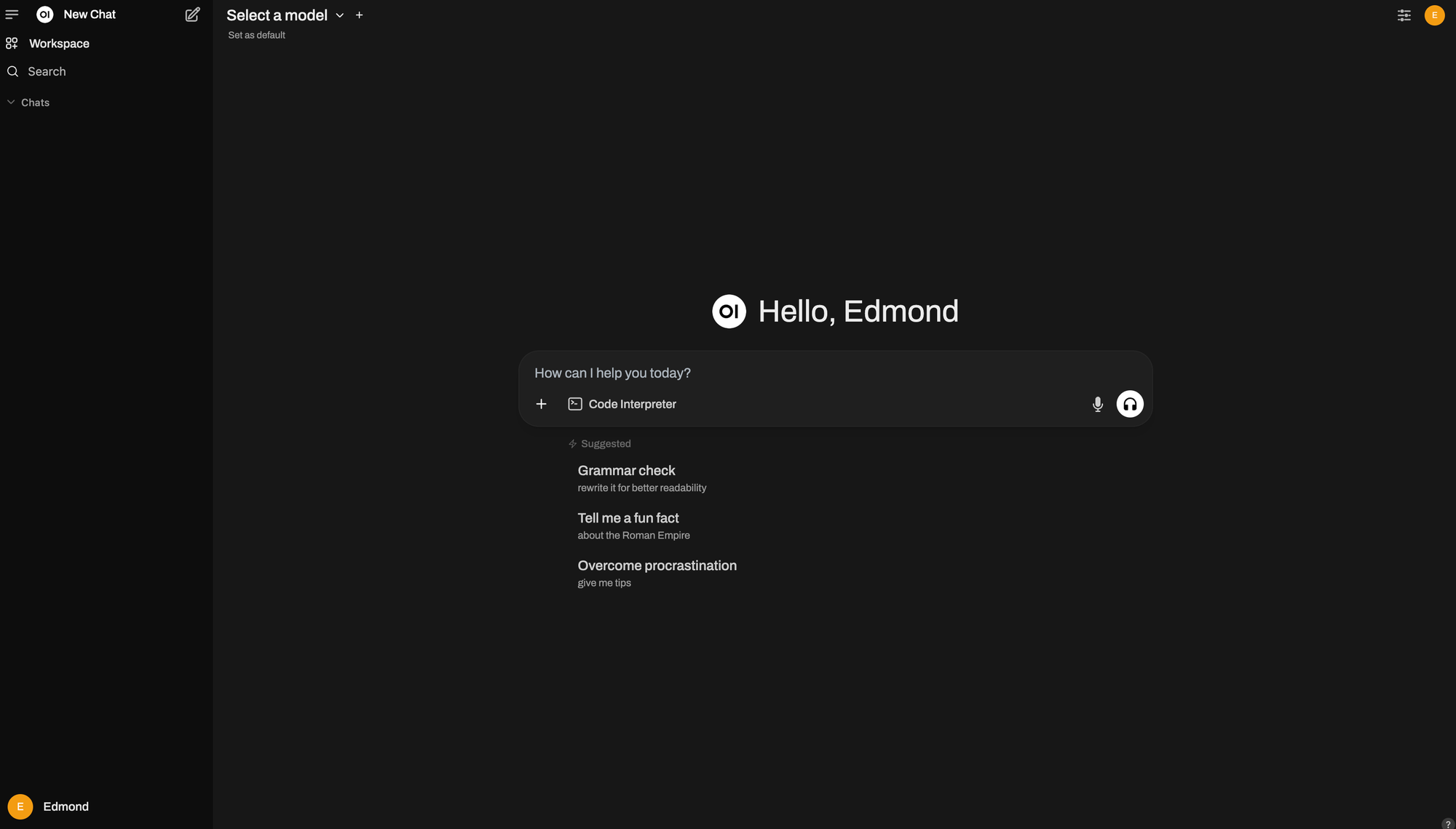

進入會見到一個很像 ChatGPT 的介面,就是 Open WebUI 了。

轉成中文介面

為習慣中文用家,大家可以先到左下角按一按自己的名字打開 Setting 頁面 General 內見到 Language,改成繁體中文就可以轉成中文介面了

LLM 介紹

然後你可以上 Ollama 網站選一兩個合適的 LLM,推薦幾個熱門的 Model:

- Llama 3.3 - Meta 開源的 LLM,晚點可能還會有 Llama 4 。

- Deepseek R1 - 中國團隊蒸餾 ChatGPT 而成的 LLM,聽說有著 ChatGPT 7成的效能,對中文的理解能力比 Llama 好。

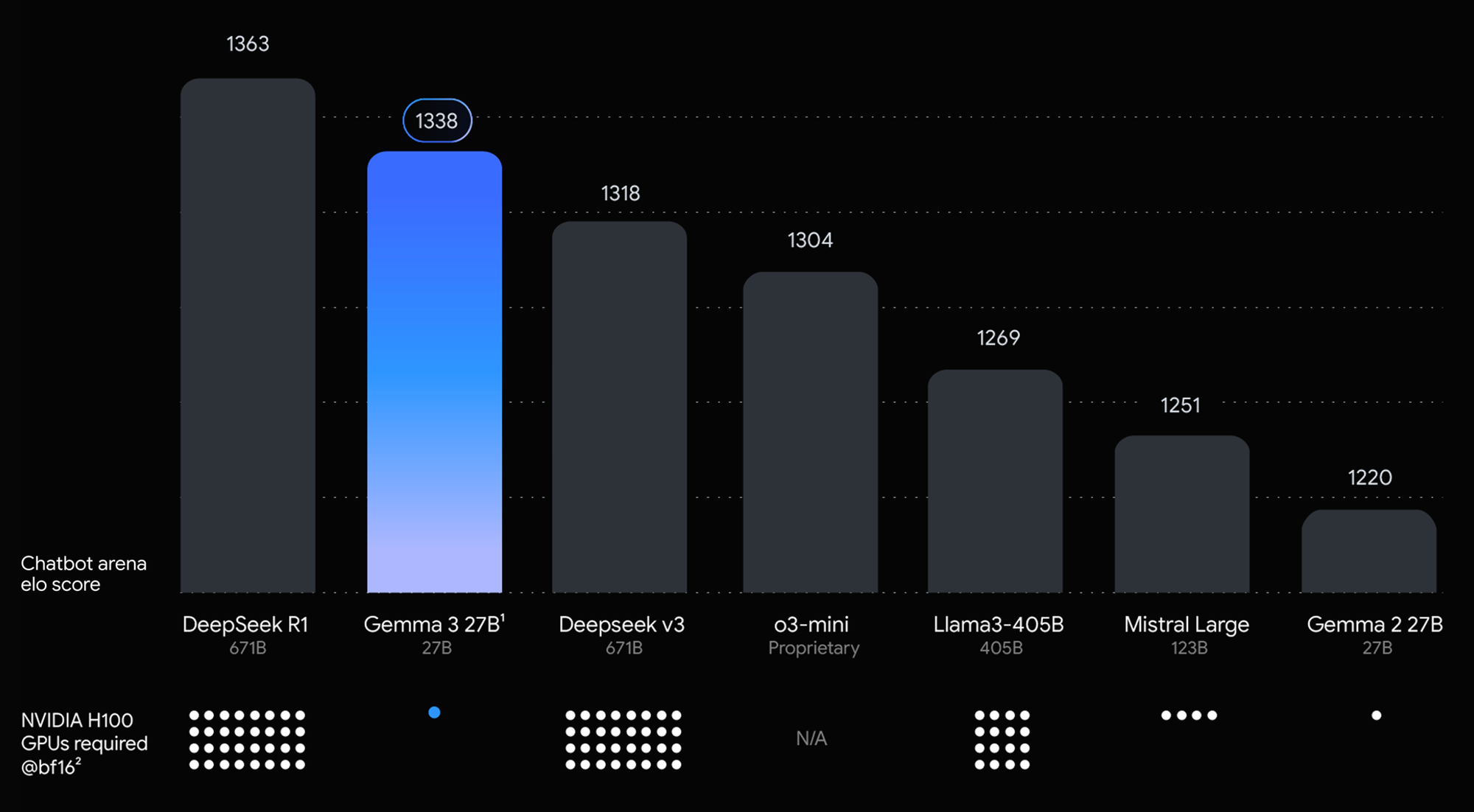

- Gemma 3 - 由 Google 開源,就是單核版的 Gemini,只需一粒 GPU 足以運行並同時有強勁的效能,對中文的支援也很好。

以下是 Google 提供的分數比較圖:

雖然 Gemma 3 跑分輸 DeepSeek R1,但相對所需的 GPU 就只需一粒,效能消耗更低,更適合本地部署做用。

下載 LLM

選好了想要的 LLM 後在 Open WebUI 也提供直接下載的方法,只要記住你想要的 Model 名。

如果想安裝指定版本的 model 也可以,部分 model 會有不同 B 的版本,好像 Gemma 3 就有 1B/4B/12B/27B,那個 B 是指有多少個 billion 的參數,參數越大,理解力及生成力就越強,當然所需的資源也會比較多,大家可以自己選擇合適的 Model 下載。

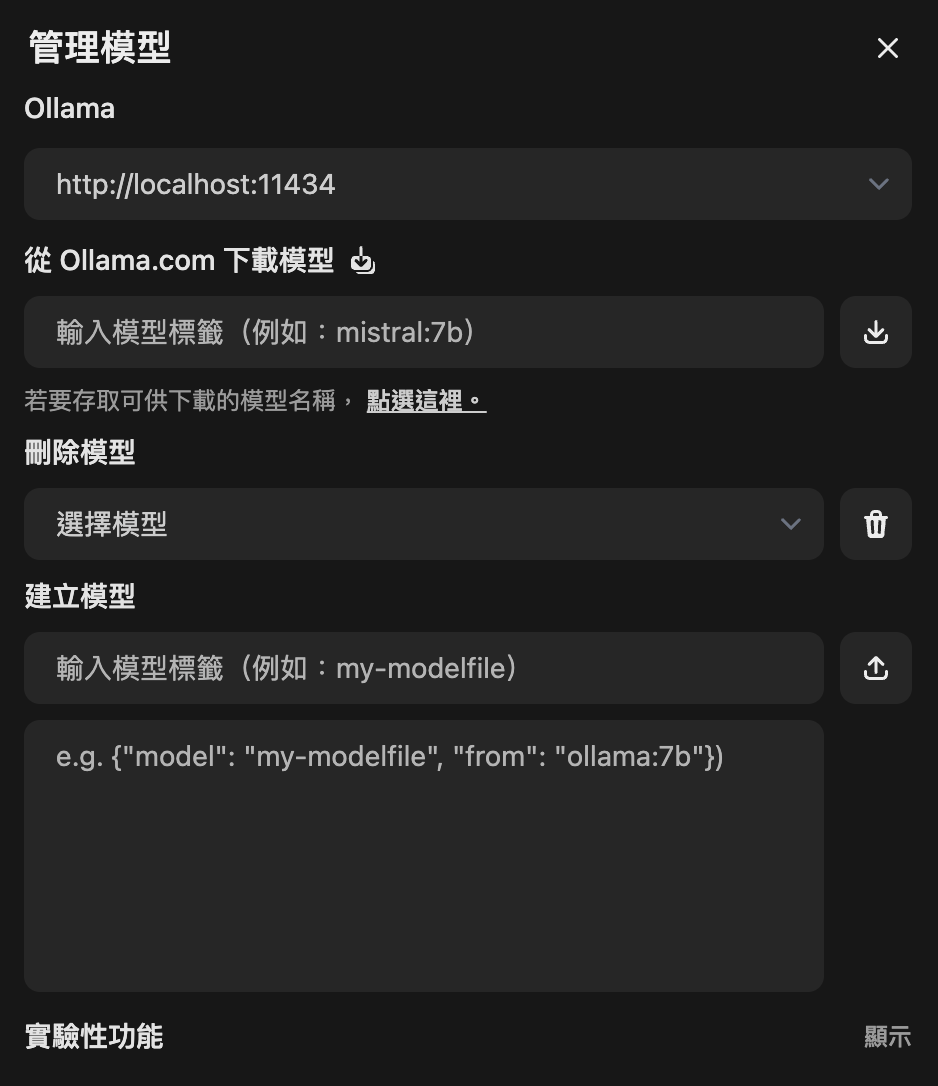

在設定 (Setting) 內打開管理員設定 (Admin Setting),在模式 (Model) 分頁中什麼也沒有,因為我們還沒有下載任何 Model,按一下右上角的下載按鈕打開管理模式,就會見到以下介面。

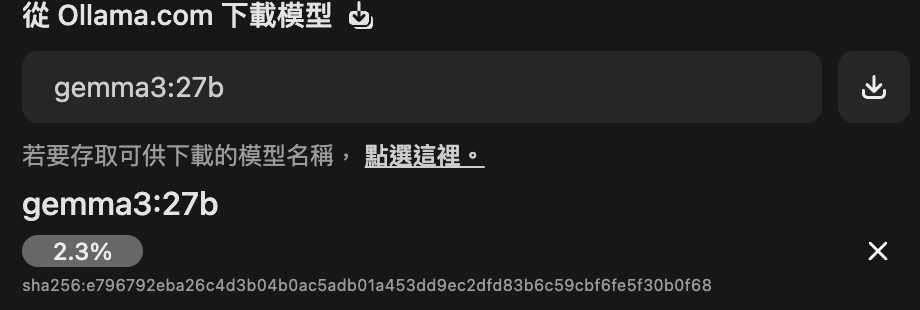

在從 Ollama.com 下載模式輸入你想要的 Model 名,例如我要下載 Gemma 3 的 27B 版本,在 Ollama 找到了 gemma3:27b,這個標籤再按右邊的下載按鈕就會開始下載,由於一般 LLM 容量都不少,要花一點時間來下載。

不想要的 Model 也可以在下面選擇刪除掉,以免花費太多空間。

如果想用一些非 Ollama 的模型也可以打開最下面實驗性功能自行上載到 Open WebUI 中使用。

下載完成後關掉管理頁面,在左上角選擇你的 Model 就可以開始對話

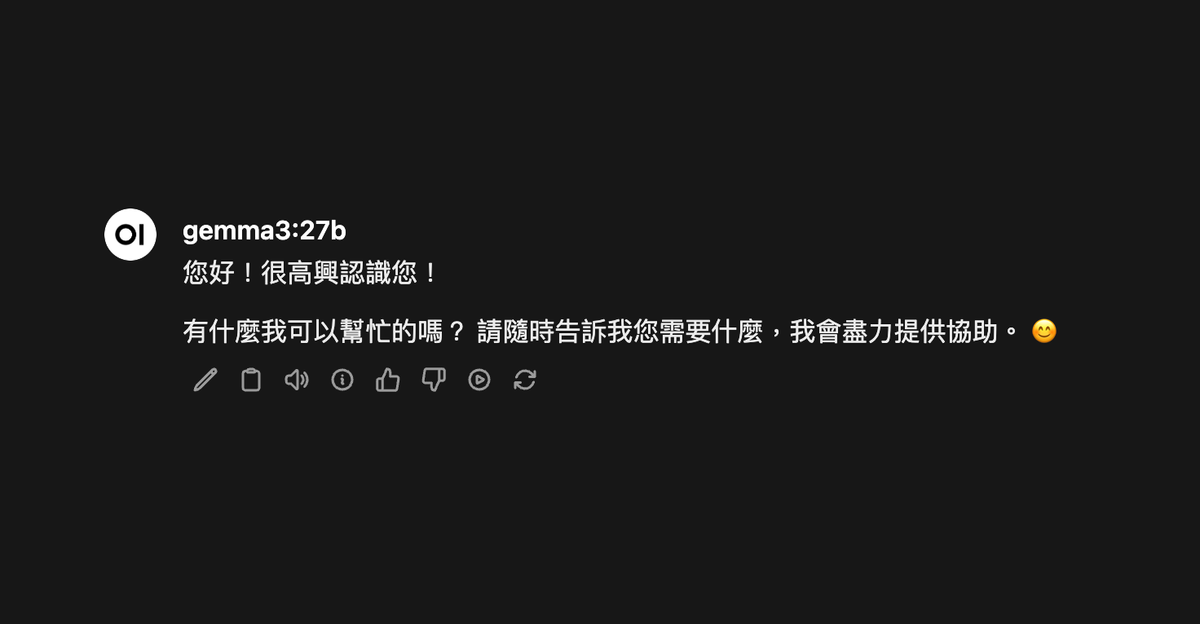

預設使用繁體中文回應

有時你沒有提醒,或者你只說了英文字,Model 就會忘了用繁體中文回應,其實可以預設繁體中文回應的。

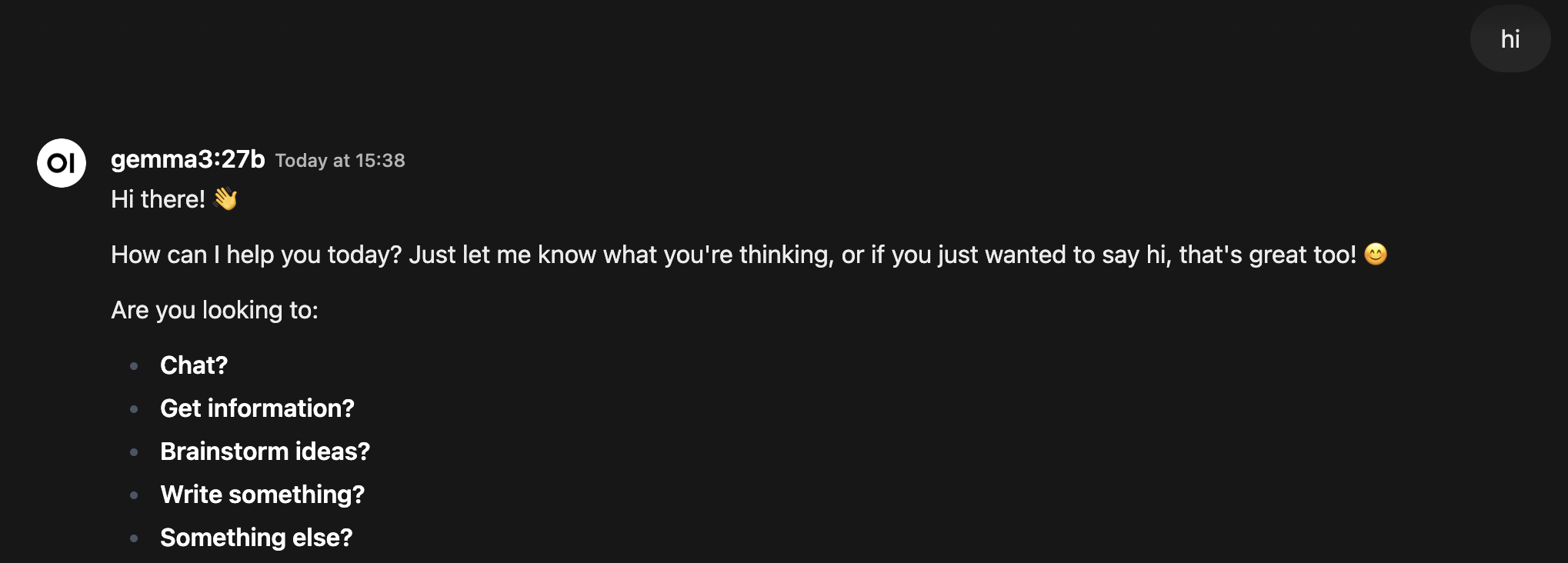

在設定可以見到 系統提示詞,這個系統提示詞會在每次對話時都讓 Model 記住,我就加上一句使用 繁體中文回應 再 Hi 一下看看會怎樣。

你也可以預設一些身份或語氣給 Model,以配合你的使用需要。

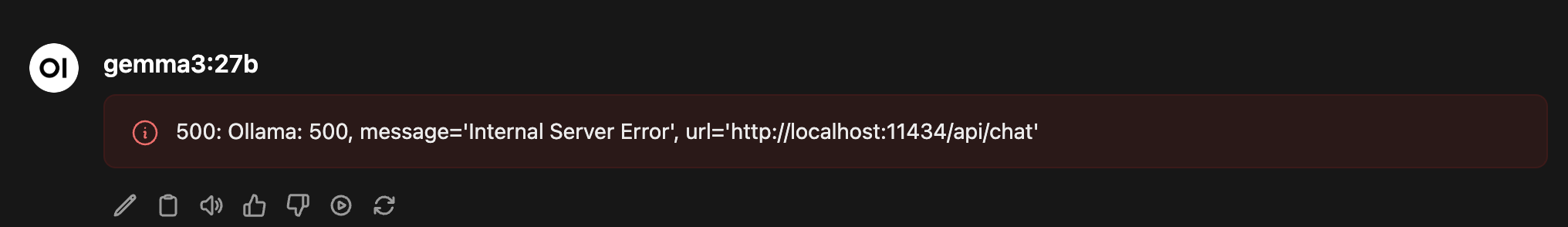

為什麼會有 Error?

相信有部份人在發送訊息後會見到紅色的 Error 框框,是設定錯誤了嗎?

如果你可以見到 Open WebUI 介面,應該沒有什麼設定錯誤了,但是這個情況多半是你電腦效能不足,畢竟 gemma3:27b 也是一個巨大的模型。你有兩個選擇可以做的:

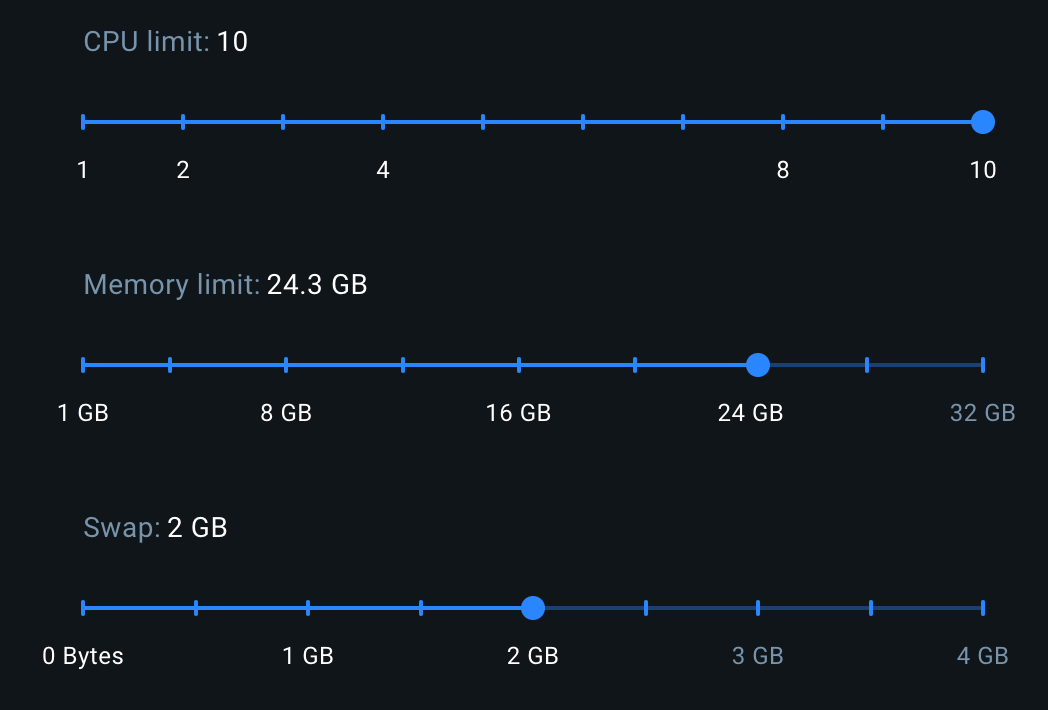

如果你電腦是用 Nvidia GPU 的話就安裝 Nvidia GPU 版本,效能會有顯著起升,也可以在 Docker Desktop 設定更多的記憶體,預設給 Docker 的記憶體應該有 8GB 左右,最少要改到比你的 Model 多,Swap 也可以增加一點。

如果沒有 GPU 記憶體也不多,選用較少的 Model 是比較輕鬆的選擇,畢竟不是每人也有超級電腦可以用嘛。